robots协议是什么?robots协议又叫做爬虫协议,是为了给搜索引擎这些爬虫看的文件,告诉搜索引擎哪些网页能抓取,哪些不能抓取,比如一些不重要的css、js或者后台资源,这些东西通常就会写在里面,毕竟这些东西被搜索引擎抓取之后对于网站排名没有任何帮助,还会浪费抓取配额,导致该被抓取的页面抓取少了,从而影响收录和排名的效果,当然配置不当,还可能会导致原本该被抓取的页面,搜索引擎不去抓了,所以学会如何正确配置robots协议是每一个站长必须要学会的一个技能!

robots协议怎么设置

1.创建一个txt文本,名字叫做robots

2.robots这个文件是放在网站根目录下面的,例如woshihuangbin.com/robots.txt

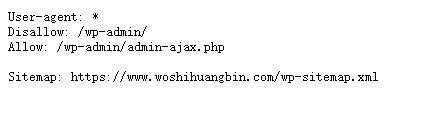

3.robots里面的格式也有讲究!正确的写法如下:

User-agent:* :代表所有搜索引擎爬虫,执行以下协议。

User-agent: baiduspider (代表百度蜘蛛,执行以下协议。)

User-agent: Googlebot (代表谷歌蜘蛛,执行以下协议。)

Disallow: / (禁止抓取本站所有链接)

Disallow: /wp-admin/ (禁止抓取带有/wp-admin/的链接)

Allow: /wp-admin/admin-ajax.php (允许抓取/wp-admin/admin-ajax.php)

Sitemap: https://www.woshihuangbin.com/wp-sitemap.xml (告诉搜索引擎网站地图链接,可以顺着这个地图里面的链接抓取。)

评论